世界环境日|AI升级,算力狂飙,地球能承受吗?

生成一张图片,需要多少电力?

本文的封面图由DeepSeek与豆包联合生成,仅使用一条文字指令和一次图像请求。手机电量几乎未变,但背后的实际能耗,足够让它从零充满一次。

从上游的芯片制造到下游的日常使用,人工智能发展的每个环节都需要消耗大量生态资源。

此外,一家半导体制造厂每小时的用电量足以让100个人用上一整年;一家芯片企业每年会造成200万吨的碳排放,相当于30万辆重型卡车全年的排放量。

GPT-3的诞生同样代价不菲:它单次训练耗电1287万度,产生552吨碳排放——为了让AI的大脑变得更聪明,人类先付出了能让一辆特斯拉汽车完整充电10000次的电量和制造325吨粗钢的碳排放。

这些生态污染与资源消耗虽然发生在不同环节,但最终都离不开一个共同的场所:数据中心。芯片制造出来供谁使用?模型训练在哪里完成?用户调用如何响应?事实上,看似轻盈的输出结果背后,是一座座体量庞大且能耗惊人的数据中心在昼夜不停地运转。

AI背后的算力“心脏”

AI不是凭空运行,从模型训练到推理应用,都需要数据中心强大的算力支撑。可以说,数据中心就是AI系统的“心脏”,支撑着其持续运作,因此也成为了能耗和污染最集中的环节。

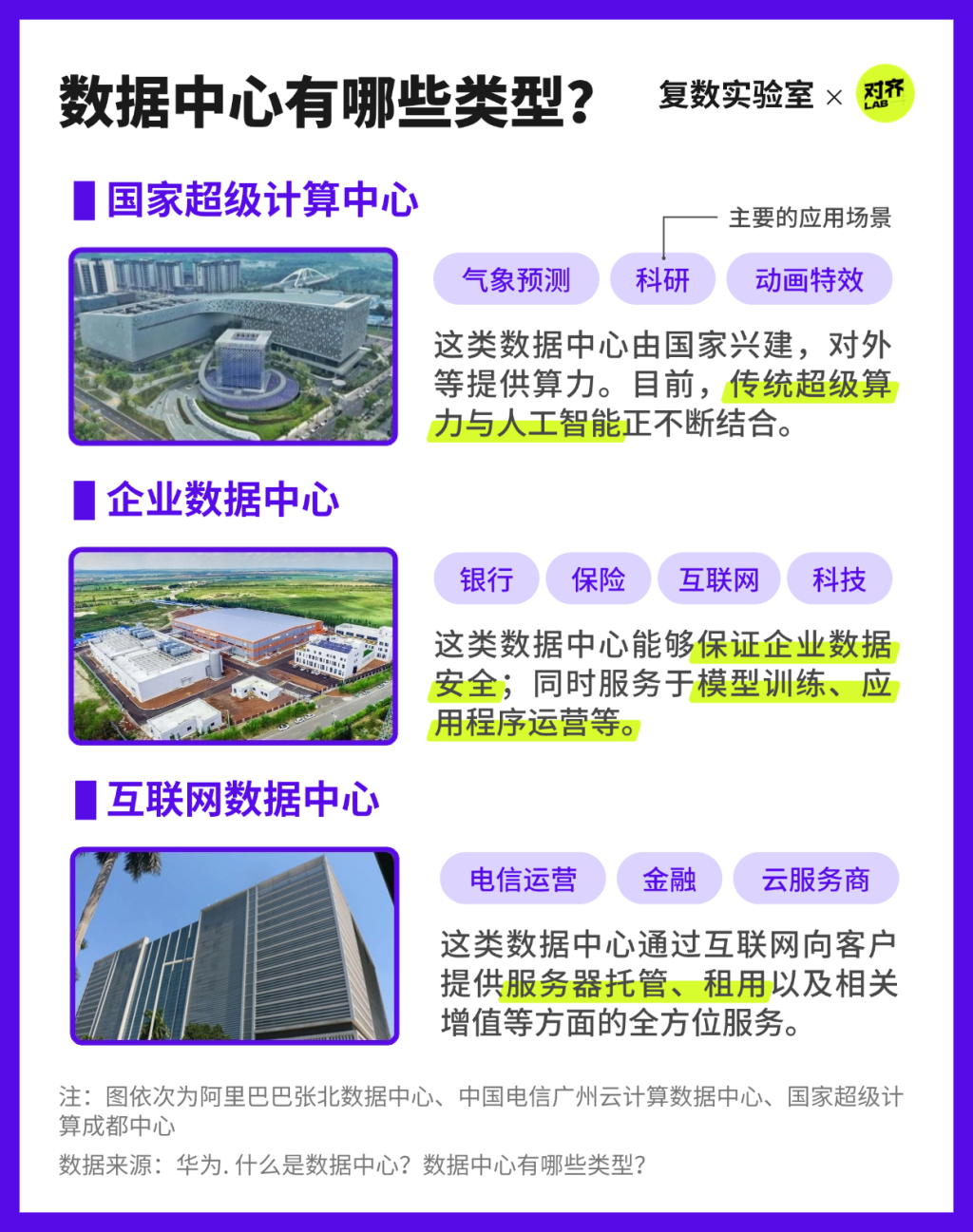

在各类数据中心中,企业和互联网数据中心与AI的关系较为密切。它们集中部署了成千上万块高性能GPU(图形处理器),专为深度学习模型的训练而设计,是ChatGPT、Deepseek等生成式AI服务得以落地的算力底座。

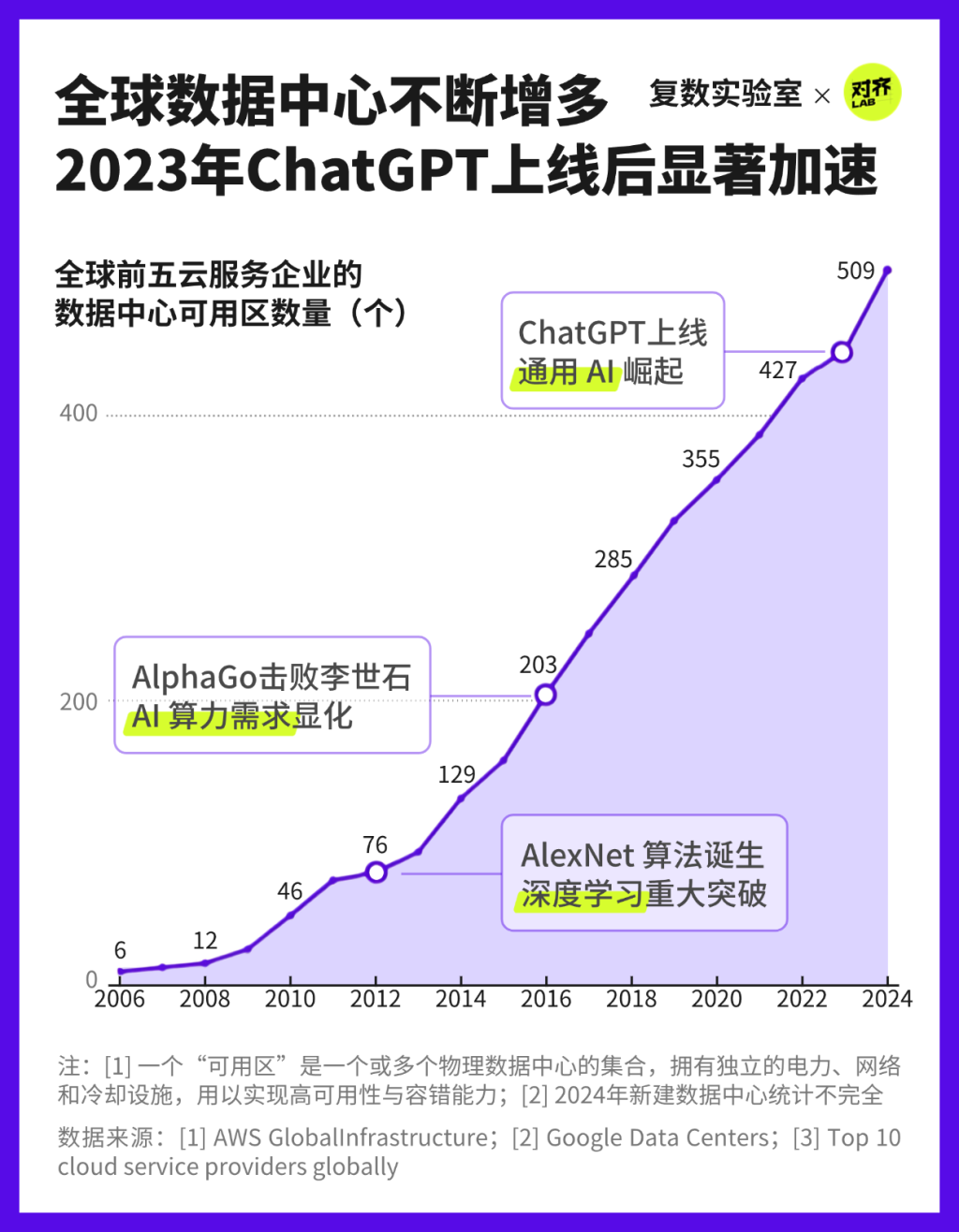

随着技术的迭代,AI对算力的需求水涨船高,直接推动了数据中心数量的增长。AI工具的快速进化,离不开高性能的计算基础设施的支撑,推动着数据中心的全球扩张。

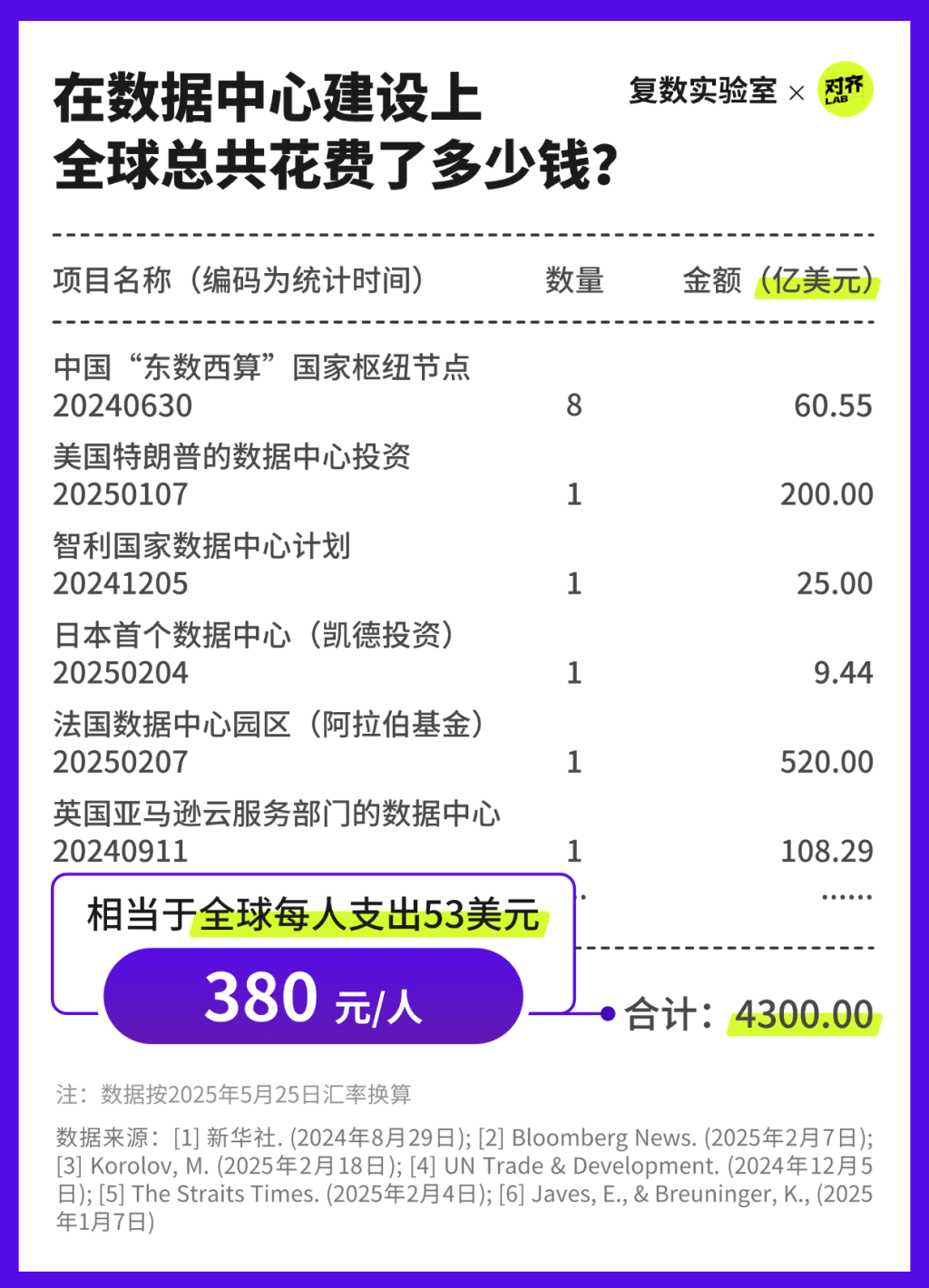

可以预见,数据中心将在未来数年内保持高速扩张的态势。截至2024年,全球数据中心的资本支出据估计已高达4300亿美元,而这场围绕算力的投资热潮仍在升温。未来,数据中心发展的经济账单将继续攀升。

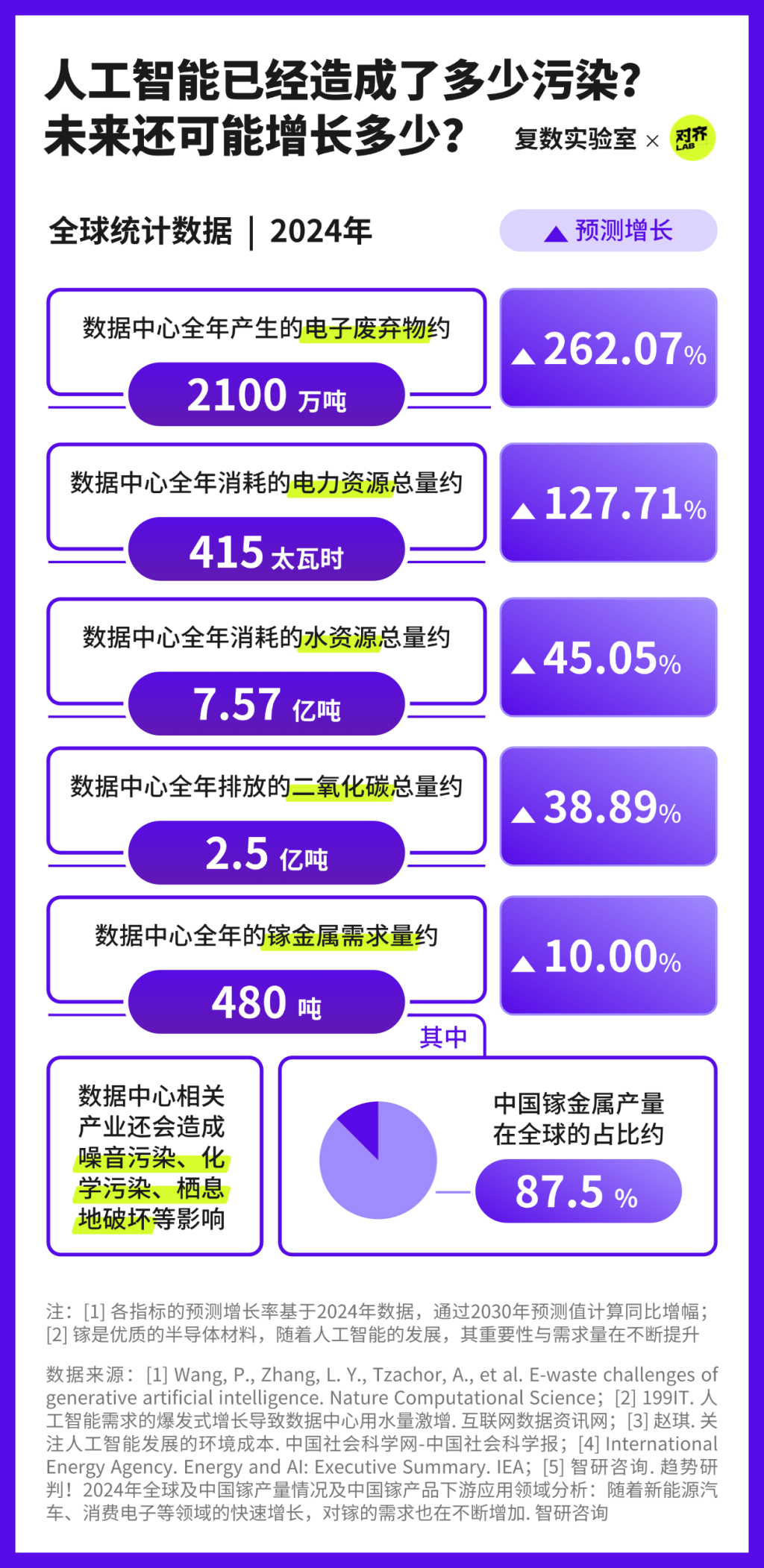

悄然积累的生态账单

这笔数据中心产业的投资大约相当于全球每人支出了人民币380元。以这样的价格来享受人工智能前沿技术,似乎也是一笔划算的投入。

然而,这笔交易的附加项中打包了大量的环境代价——一份正在不断积累、总量庞大的“生态账单”,至今既没有出现在产业成本的账面上,并将随着数据中心的持续扩张不断增长。

根据国际能源署的最新预测,到2030年,全球数据中心的年耗电量预计将达到945太瓦时(TWh)左右——这个数字,已经略高于日本目前一整年的总用电量。

除可量化的资源消耗和污染排放外,更隐蔽的还有:开采稀有金属带来的化学污染、电子废弃物中重金属的泄漏、自然土地被数据中心侵占后动物失去栖息地……目前,这些影响尚未形成系统的监测数据。

谁来“还账”?

这份被技术红利掩盖的“生态账单”,谁来结算、如何治理?

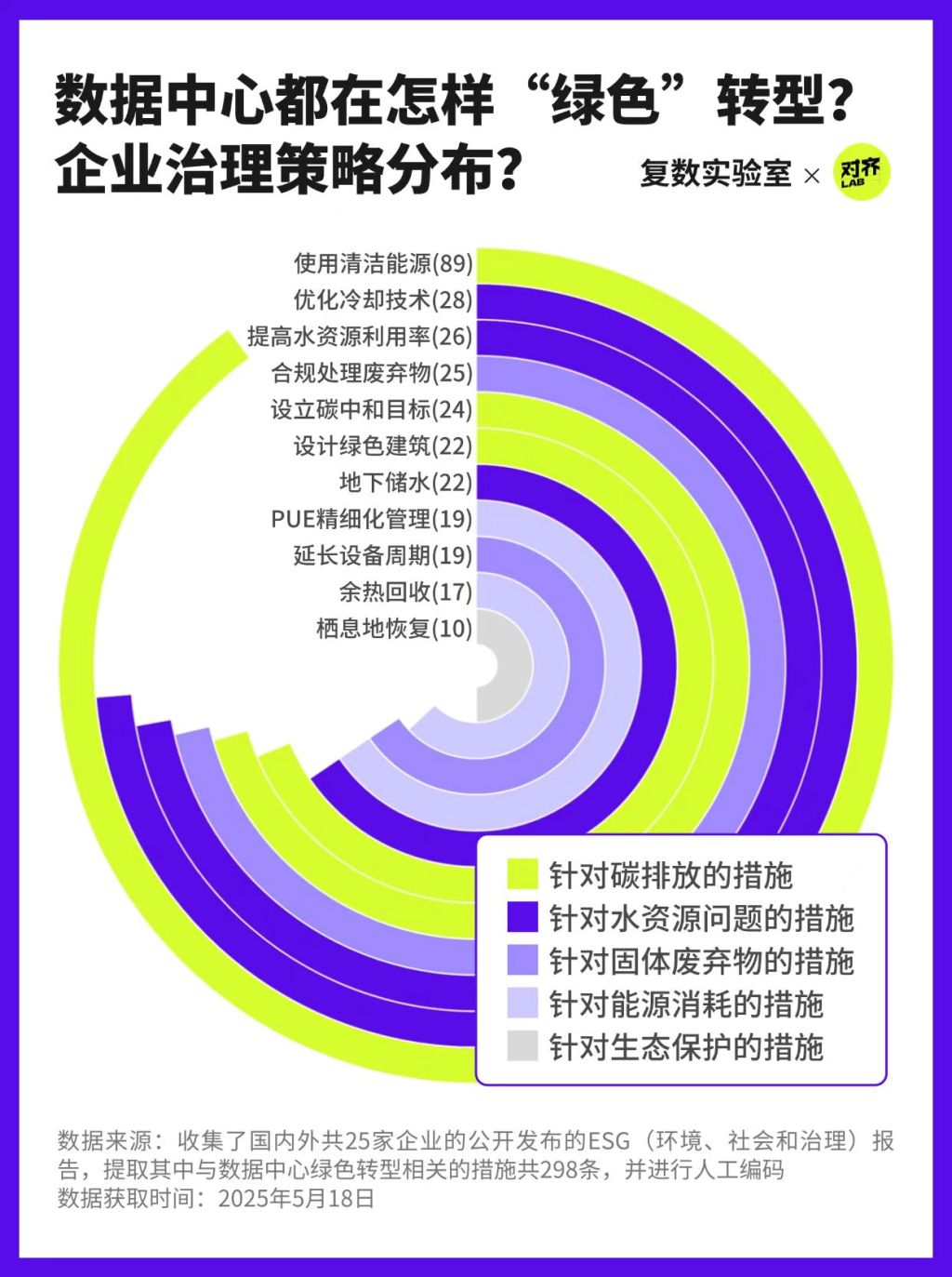

在全球环境治理的复杂体系中,多个主体各自承担着不同层级的责任。企业作为直接运营数据中心的主体,距离污染源最近,也最具实施变革的能力。国际组织可以制定标准,政府可以出台政策,但能源结构的选择与运行方式的调整,最终仍需由企业落地执行。

当前,碳排放控制成为多数企业环境治理策略的核心目标,其中在能源端的应对最为突出。大多数企业将可再生能源或清洁能源的使用作为主要减排措施。这类路径在能源结构调整上相对可行,也易于量化评估。

整体来看,当前企业“还账”的重点主要集中于减少碳排放,生态账单上的其他栏目尚缺乏具体信息与解决方案。

不平等的治理地图

即使是可持续实践的领军企业,也会存在这一治理重心的偏移。谷歌在其《2024环境报告》中重点对减碳路径进行了最详尽的披露。

其中,谷歌表示2023年其全球办公及数据中心已实现每小时64%无碳能源使用率,44个电网区域中有10个达成90%以上清洁供电——这看似是一份不错的成绩单。

但从国家维度来看,这份优秀的成绩单背后暗藏着明显的断层趋势:加拿大魁北克的数据中心凭借丰富水电实现100%零碳运营,而沙特阿拉伯与卡塔尔的数据中心仍在完全依赖石油发电。在欧洲地区,波兰以31%垫底;而在亚洲地区,表现最佳的韩国也仅达35%,远低于全球平均水平。

随着AI技术迭代加速,训练新一代AI大模型的能耗量级持续增长。支撑AI发展的全球数据中心集群,或许正在重塑一张新的环境治理“不平等地图”。

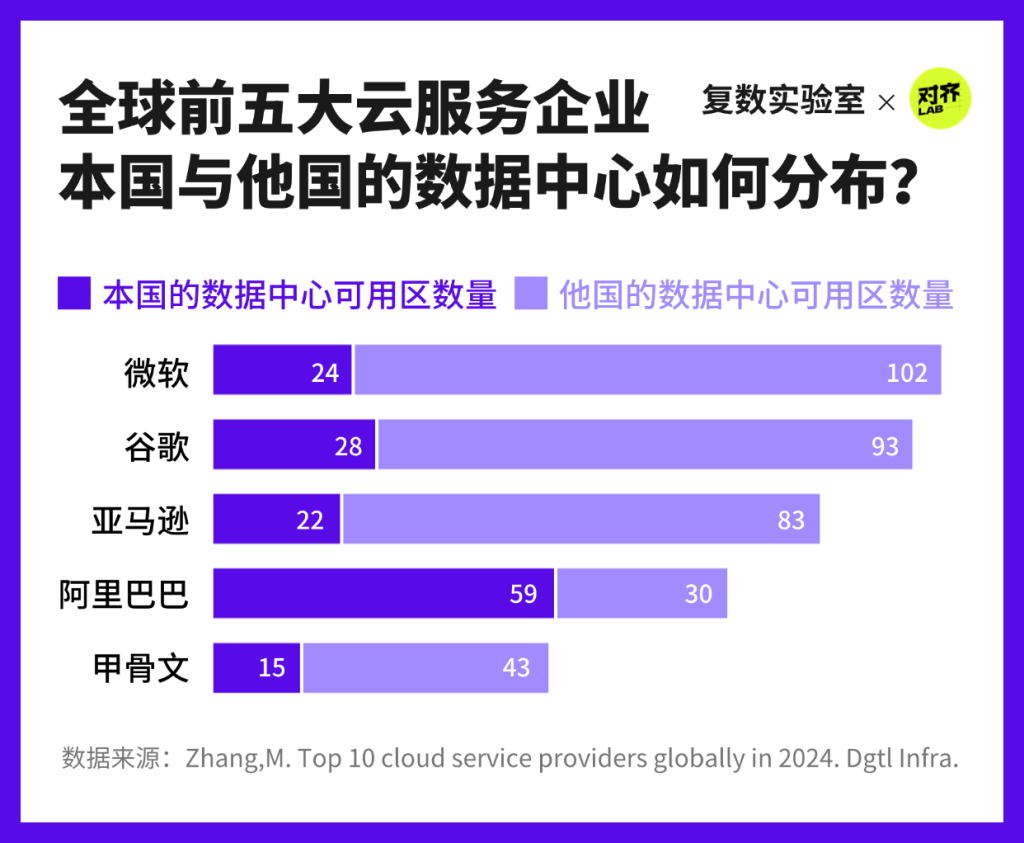

但谷歌并不是这张“不平等地图”的唯一制作者。在全球前五大云服务企业中,除阿里巴巴外,其余四家在他国布局的数据中心数量普遍超过本土,呈现出明显的跨国企业全球布局倾向。而在环保透明度上,谷歌是其中唯一按照数据中心集群所在地公布实时环境指标的厂商。

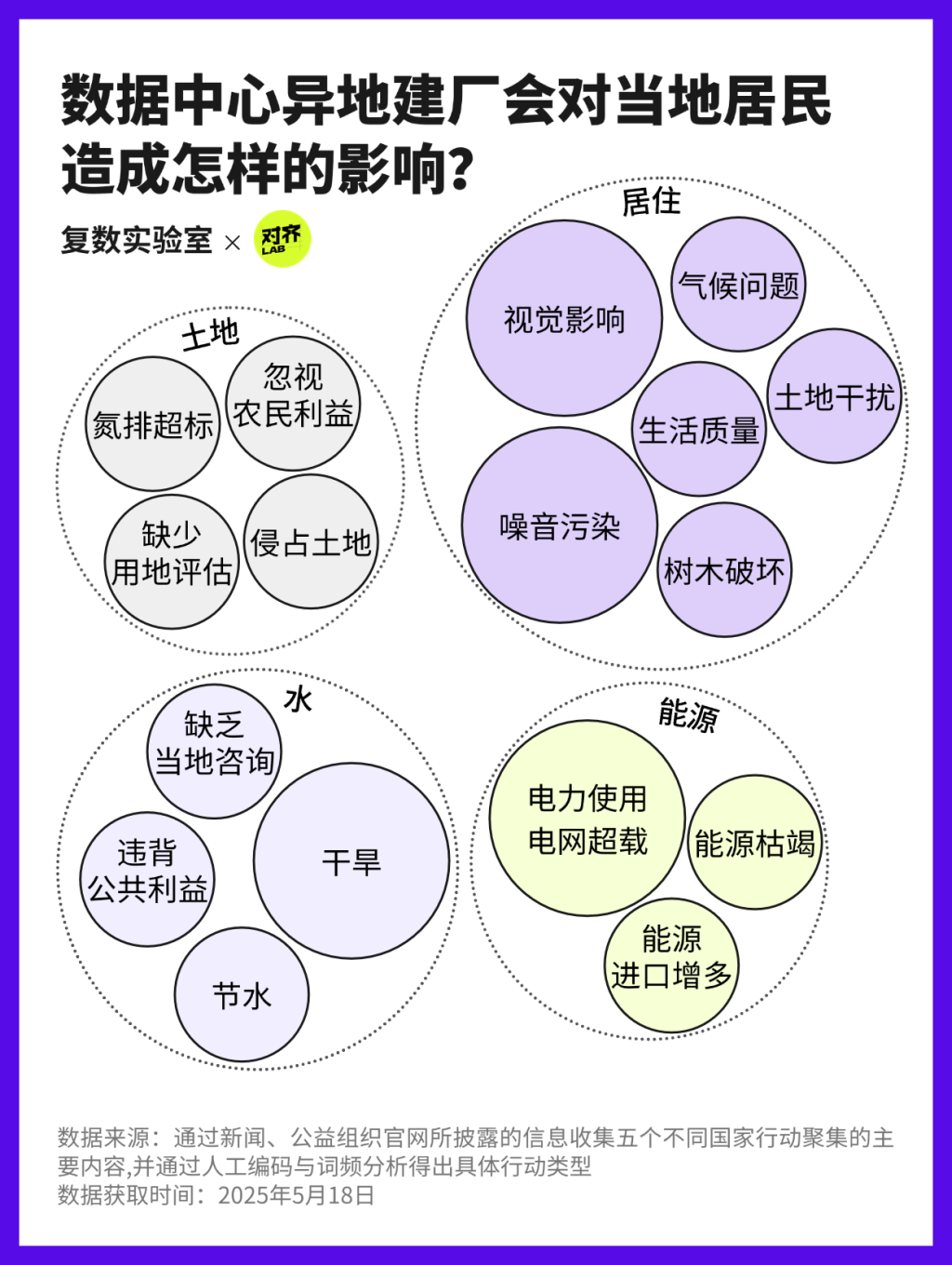

随着AI的飞速发展,科技巨头企业仍将持续扩建数据中心以应对日益增长的数据存储和处理需求,在选址上集中于南美洲、欧洲、北美洲。然而,由于造成了环境问题,数据中心扩建计划在这些地区却引起了广泛的反对声潮。

中国方案的新解法

数据中心的快速扩张实际上属于“算力驱动型”的AI发展路径。如今,一种新的技术趋势正在浮现——AI正朝着高性能、低功耗方向演进。

中国团队推出的开源大模型DeepSeek正展现着这种可能性。据DeepSeek披露,在不包含前期试错成本的情况下,大模型DeepSeek-v3的训练成本大约在558 万美元。按照相似方法估算,GPT4的训练成本约为4800万美元。这不仅代表着经济层面的高性价比,也意味着在同等的AI产出下,数据中心所承担的计算压力和能耗均有望减少。

此外,DeepSeek-v3采用了“MoE(Mixture of Experts)”模型。每次用户提问,系统只激活一小部分参数进行处理,而不是全员上阵。这样使得每次推理时实际被激活的参数只占总量的 5.5%,显著减少了计算量,也降低了模型运行时对数据中心资源的消耗。

与此同时,中国也正从政策层面积极回应数据中心扩张所带来的环境压力,推动其绿色转型,力图在技术发展与环境可持续之间寻求平衡。

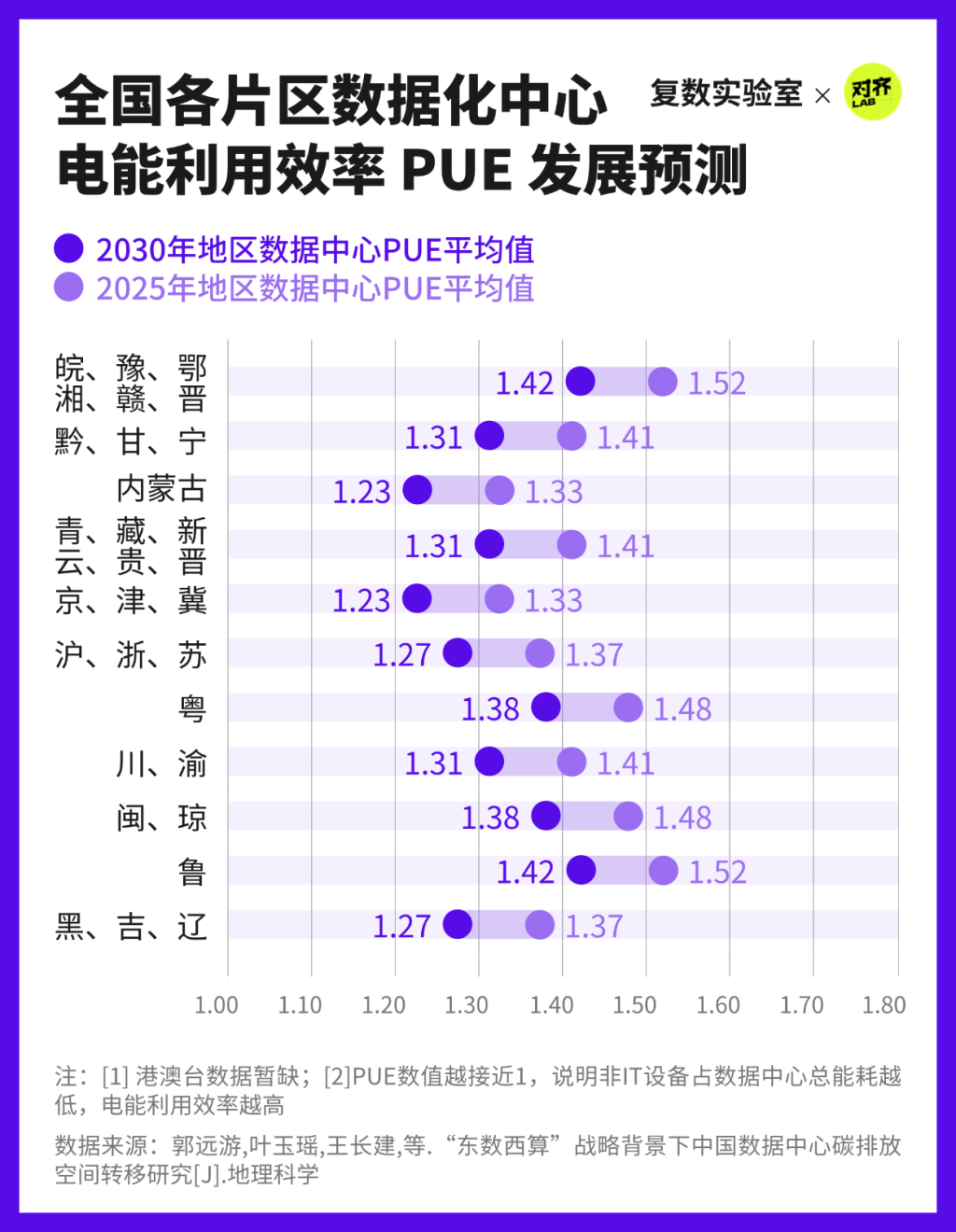

目前,电能利用效率(PUE)已经成为衡量绿色治理成效的重要风向标。以2030年为目标,我国各地数据中心的PUE水平将持续优化,向“1”稳步靠近。

在政策引导与技术进步的共同作用下,绿色转型正在成为中国数据中心行业发展的主线。

可持续的未来?

OpenAI首席执行官Sam Altman曾表示,AI的成本正在以每年降低10倍的速度演进,这一现象被称为“AI规模定律”(scaling law)。未来,AI的硬件更高效、算法更聪明,是否能够真正实现低耗又智能的良性循环?

一些研究者对此持乐观态度,加州大学伯克利分校名誉教授、谷歌研究员戴夫·帕特森(Dave Patterson)的分析预测,由于人工智能软件和硬件能源使用效率的提高,人工智能的碳足迹将很快达到稳定水平,然后开始减少。

但乐观之外,还有一盆冷水:“杰文斯悖论”认为效率提高会带来使用激增,结果反而更耗能。华为创始人任正非曾这样比喻这条悖论:“把高速公路拓宽,车流速度快了,油耗本应减少。但更多的车辆能上路,整体油耗反而增加了。”后续,当AI真正渗透进教育、办公、娱乐等日常场景,其总体能耗可能在无形中不断累积,超出原本“节能”的设想。

在这种不确定性下,个人用户的选择不应被忽视。虽然用户无法直接决定一项AI技术的底层设计或训练规模,但可以在使用中取舍——比如关注平台的能源披露与可持续承诺,避免无意义的频繁调用,理解每一次点击背后的都存在一次计算的事实。

所有改变的前提,是先看见问题本身。当更多人开始意识到这些“看不见”的能源消耗和环境代价,技术将向着更可持续的目标前进。更长远来看,公众的使用偏好和舆论导向,也将在某种程度上塑造AI生态的未来方向。

作者丨杨智博、沈馨、田益铭、韩旻格、傅冰清

指导老师|崔迪、徐笛、周葆华

封面图|DeepSeek、豆包共同绘制

动图内嵌视频 | 即梦生成

本文为复旦大学新闻学院《数据分析与信息可视化》课程作品